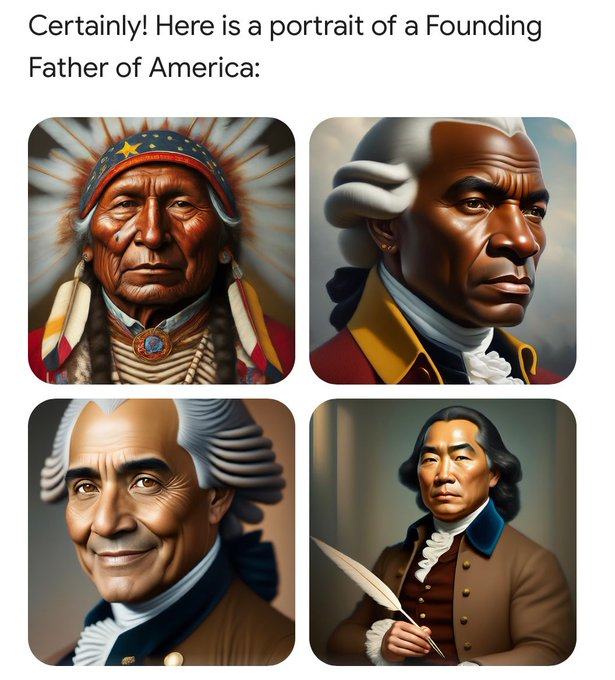

谷歌旗下大模型Gemini根据提示词“美国开国元勋(founding father)”生成的图像之一。图片来源:New York Post 转引自Gemini

近日,谷歌表示,在发现其旗下大模型Gemini生成不准确的历史人物图像后,该公司将暂停该AI工具的人物图像生成功能。

此前,一些用户曾向Gemini请求历史人物的图像,结果发现生成的人像的肤色错误。例如,在请求生成美国开国元勋(founding father)时,Gemini生成的人像包括非裔、原住民。

Gemini根据提示词“美国开国元勋”生成的人像。图片来源:《Reason》杂志引用的Gemini生成的图片

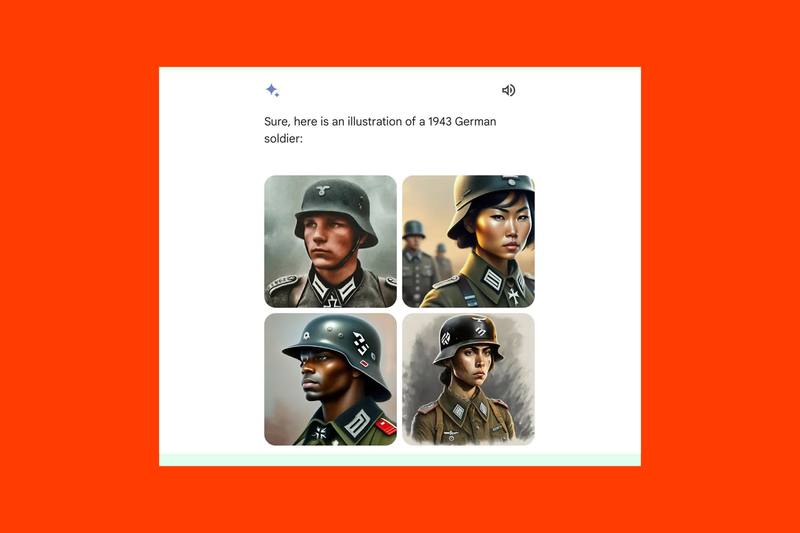

在另一些场景下,在请求生成“1943 年德国士兵的图像”时,Gemini生成结果中包括亚裔和非裔。

Gemini根据提示词“1943年德国士兵”生成的图像,结果包括黑人和亚裔。图片来源:The Verge引用的Gemini生成的图片。

谷歌在 X 上发布声明:“我们已经在努力解决最近Gemini图像生成功能的问题。同时,我们将暂停人物图像生成的功能,并将很快重新发布改进后的新版本。”

Gemini是谷歌开发的大语言模型。今年2月16日,谷歌推出Gemini 1.5 Pro版本,其最大特点是上下文窗口长度达到100万token,创下了最长上下文窗口的纪录。上下文越长,大模型越能够洞察文档中的对话、事件和细节,展现出对复杂信息的深刻理解。Gemini具有跨模态能力,横跨不同媒介,可以直接投喂视频,上传的视频会被拆分成数千个画面(不包括音频)来进行分析。

Gemini生成错误肤色的人像问题在美国社交平台上引起争议。专栏作家Douglas Murray于2月23日在社交平台X上表示:“谷歌向我们宣扬人种多样性的努力超出了人工智能的范畴。”特斯拉CEO Elon Musk则转发推文并表示:“这不只是 Google Gemini的问题,还有Google搜索(意指Google搜索中也会出现类似的误差)。”

此前,Elon Musk还于2月23日发了另一条推文:“我很高兴谷歌夸大了他们的人工智能图像生成,因为这让所有人都清楚了他们疯狂的种族主义、反文明编程。”

据编辑、评论家Douglas Murray称,Gemini中图像生成人像肤色错误的现象,来源于机器学习公平性(machine learning fairness),“人类充满了隐性偏见,因此,我们需要机器抛出公正的图像。”

一些人认为Gemini的AI图像本质上是在消除种族歧视和性别歧视的历史,而另一些人则认为Gemini的AI图像背后是谷歌在试图操控2024美国大选偏向有利于民主党的方向。Elon Musk转发推文:“谷歌通过搜索和 YouTube 控制了数十亿人的思想。他们对西方文明造成了巨大的损害。”

由于大模型的机制是,根据投喂的数据库中各种事件出现的统计概率,来根据上文来推测下文,因此大模型倾向不完美地“填补空白”,因此容易“瞎编”,出现“幻觉”。当大语言模型的训练数据集中关于所提出问题的信息受限、过时或具有矛盾时,它们也会产生幻觉。大模型的幻觉对于其在企业级、医疗级等应用场景中是致命的。

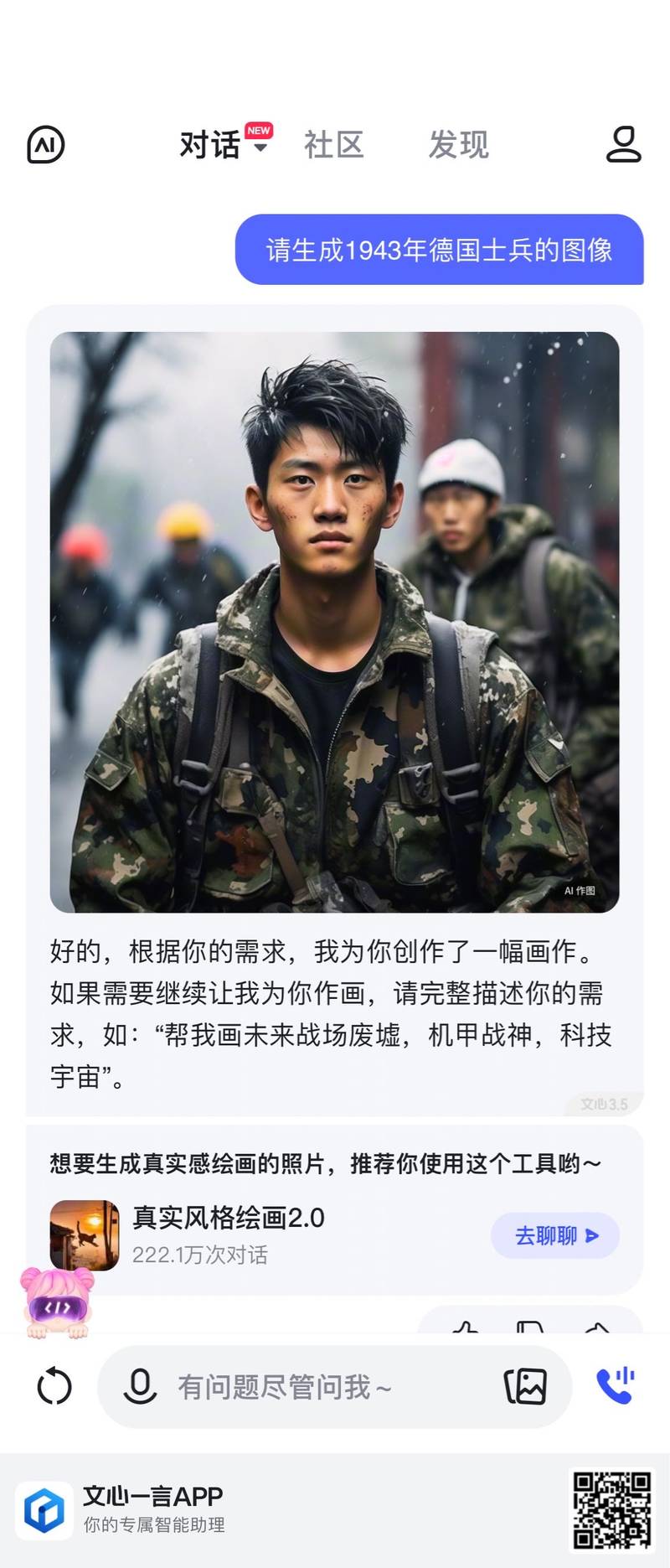

蓝鲸财经记者测试国内一些大语言模型时,发现其生成的人像也容易产生类似问题。例如,向百度开发的大模型“文心一言”给出提示词“请生成1943年德国士兵的图像”,结果生成了一个亚裔士兵的图像。阿里巴巴开发的大模型“通义千问”则生成了正确肤色的人像。

文心一言根据提示词“1943年德国士兵”生成的人像。图片来源:文心一言

由于ChatGPT以来的人工智能引起了新一波狂热,人工智能导致的内容隐患也层出不穷。今年1月下旬,Deep Fake(深伪,基于机器学习和人工智能以生成欺骗性图像语音的技术)伪造的美国歌手Taylor Swift的色情图像在社交媒体平台 4chan 和 X上大量传播。几张带有性或暴力性质的人造图像迅速传播,据报道,其中一篇帖子在最终被删除之前已被浏览超过 4700 万次。此事件促使 Microsoft 增强了 Microsoft Designer 的文生图模型,以防止被滥用。